人工智能快速发展带来新风险

近10年来,公众对数字技术的担忧主要集中在个人信息泄露和滥用的可能性上。为了缓解这些担忧,主要国家已经集中精力建立法律和制度等措施,以确保互联网用户能够控制自己的个人数据,例如EU通用数据保护条例(GDPR)。

然而,随着2022年底ChatGPT 3.5的出现,人工智能已成为热门话题,人工智能技术被引入到招聘、信贷评估以及公共部门的行政处理和审批支持等各个领域。公众的关注点已经从复杂且不断升级的算法转向数据的收集和使用方式上。

原本期望人工智能能够根据客观数据做出合理判断,但是它实际上正在造成各种意想不到的负面结果,例如强化社会歧视或提供看似合理的虚假信息。

人工智能产生的副作用大体可分为三种。第一是偏见、毒性和错误信息的暴露。由于人工智能学习的数据是从现实世界中收集的,因此有可能排除或主流化某些特定团体,包含暴力等有害内容,并且可能提供虚假答案。第二是版权问题。

生成的内容如果引用或复制现有作品,无论是否有意都可能引发知识产权侵犯问题,此类案件近期屡见不鲜。另外,关于人工智能创作的诗歌、小说等创作物版权认可度的讨论仍在继续。第三是人工智能带来的信息安全问题,即个人信息和企业内部信息泄露的风险。

表1) 人工智能引起的副作用/争议类型

| ① 曝光有偏见的、有毒的、错误的信息 |

|

| ② 版权问题 |

|

| ③ 信息保护 |

|

例如,通过实证研究发现,基于人工智能的Facebook广告,可以给用户提供量身定制的广告服务,根据种族和性别存在偏见。据透露,约85%的超市收银员职位信息暴露给女性,约75%的出租车司机职位信息暴露给黑人,而房屋销售广告则更多暴露给白人,租赁广告则相对较多地暴露给黑人。

公共部门也没有太大区别,英国内政部将人工智能用于签证审批处理工作,但据报道存在一个问题,即对白人人口较少国家的签证申请人无故延迟。最终,当局表示将检查处理系统的运行情况,并停止使用人工智能。

版权问题也不断被提出。人工智能基本上是通过现有数据进行学习的,其中一些是受版权保护的对象。利用这些数据,人工智能被训练来制作模仿特定风格或以特定方式做出书面作品。这些作品可能与受版权保护的现有作品相似甚至相同。

例如,2023年底,《纽约时报》对Open AI提起诉讼,声称AI公司未经许可使用其大量内容,侵犯了知识产权。另外,对于人工智能创作的作品版权保护范围也存在争议。针对这些争议,韩国政府于23年12月发表了《人工智能著作权准则》,并表示原则上人工智能创作成果不能被视为版权作品,不能进行版权登记。

但该指导意见并没有对人工智能创作的著作权规定进行立法,其他国家也没有对人工智能创作的著作权规定进行立法。对于人工智能产品的版权需要包含多少人类创造力,目前社会尚未达成共识。

随着人工智能的普及,侵犯个人隐私的事件也迅速增加。以训练人工智能为借口,苹果、谷歌、微软等跨国企业收集了用户的语音信息,特别是苹果为训练Siri收集了敏感的个人医疗、信用信息等,从而引发了争议。

为了应对人工智能带来的各种风险,许多国家纷纷通过法律对高风险人工智能进行界定并规定分类标准。后文将介绍的《EU人工智能法案》(Artificial Intelligence Act)将人工智能风险分为四个等级:△极小或无风险、△有限风险、△高风险和△不可接受的风险,并适用不同危险度的差别化限制。

该法案将重要基础设施、人工智能面试和人工智能贷款审查等能够左右教育、就业及金融服务的定义为“高风险”;将包含社会歧视或操纵人类行动的人工智能定义为“不可接受的风险”。

此外,美国的《算法问责法案(The Algorithmic Accountability Act))将涉及重大决策的人工智能归类为“高风险”,例如评估和认证、教育和职业培训、员工管理、抵押贷款和信贷等金融服务以及法律服务、电力、水等。

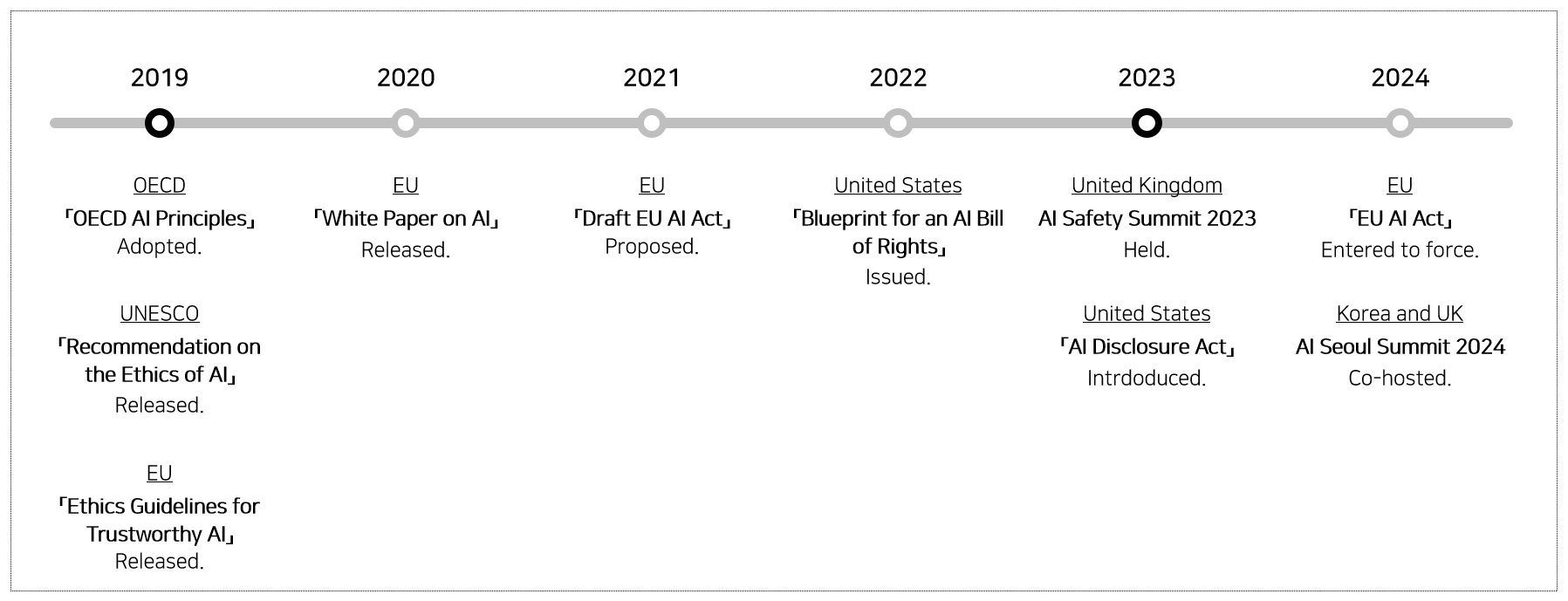

为预防人工智能对人类生活产生巨大负面影响,从2010年代末至今,1)多边机构、2)国际组织和3)各国政府正在做出各种努力,包括准备宣言、建议和立法。

人工智能风险管理的全球趋势

【图1】 全球主要AI风险应对法律政策。

多边会议—人工智能峰会

作为国际社会应对人工智能风险的一环,人工智能峰会于2023年11月1日至2日在英国布莱切利公园举行,为期两天。在此次人工智能峰会上,韩国、美国、中国等28个国家一致同意并宣布了一份关于人工智能安全的联合声明,该峰会强调国际合作的必要性,以及尽量减少人工智能可能给人类带来的风险。

主要协议内容是: △ 呼吁和倡导以人为本,希望AI科研机构、企业等以负责任的方式,设计、开发和使用AI; △ 开发在教育/公共/安全等领域里任何人都可以受益的人工智能;△ 向使用人工智能的所有利益相关者,赋予确保人工智能安全的责任;△加强国际合作的基础上寻找人工智能问题的解决方案。

峰会由多个国家元首聚集在一起讨论安全、可持续的人工智能并发表共同宣言,值得关注的是强调了开发者的责任和国际合作的重要性。但仅限于发表共同宣言,没有提出具体的执行方案。不过,韩英联合主办的AI峰会定于24年5月再次举行,为落实峰会宣言制定具体实施方案,并对峰会的后续措施进行中期审查。

OECD人工智能建议

2019年5月,OECD通过了“OECD人工智能建议(Council Recommendation on AI)”,以实现可持续和可靠的人工智能。具体来说,该建议包含创新、可靠、尊重人权和民主价值观的人工智能原则。

为了实现这一点,△首先,包容性增长、增进福祉、减少社会不平等现象;△其次,在整个人工智能系统生命周期中遵循以人为中心的价值观,例如自由、隐私、平等和多样性; △ 第三,为了增进对人工智能系统的理解、确保透明度和可解释性,需要人工智能开发人员的努力;

△ 第四,系统性地克服整个生命周期的隐私和数字安全等风险;△ 第五,需要人工智能开发人员承担责任,使人工智能系统保持最新状态,确保其正常运行。该建议具有比宣言更强烈的建议效果,它强调了人工智能的包容性、公正性、多样性和透明度。

UNESCO关于人工智能伦理的建议

UNESCO在 2019年11月的UNESCO大会上编写了《人工智能伦理建议》。该建议包括人工智能应遵循的4个价值观、10个原则和11个政策建议。首先,人工智能应追求的四大价值观是△人权、自由、尊重他人,△促进环境和生态系统繁荣,△确保多样性和包容性,△和平、公正、互联的生活等。

10条原则包括进行人工智能影响评估,禁止将人工智能系统用于公共监视目的以及设计参与性和协作性治理。该建议意义重大,因为它是由 193 个UNESCO成员国签署的全球人工智能相关协议,但与OECD的建议一样,该国际组织的建议本质上不具有约束力,与OECD的公告有很多重复之处。

EU人工智能法案

虽然国际组织(OECD、UNESCO)的建议为实现人工智能系统的透明度和公正性奠定了基础,并且起到了防止人工智能歧视的里程碑作用,但这些建议只能产生建议性的效力。

因此,随着人工智能的快速发展,为了防止偏见、歧视和侵犯隐私权等负面影响,并确保人工智能得到更安全的利用,迫切需要制定法律具体规范相关问题。

欧盟(EU)在2019年发布了《可信赖人工智能道德准则》,2020年发布了《人工智能白皮书》,并于2021年4月制定了欧洲关于人工智能统一规范的《EU人工智能法案》草案。此后,随着GPT等新技术的出现新的问题也随之而来。

最终于2023年10月,欧盟27个成员国一致同意《欧盟人工智能法》,这是一项规范人工智能技术的法案,并于2024年3月欧洲议会上通过了该法案,虽然还没有得到各国的认可,但已经跨过了主要障碍。

首先,欧盟根据该法案将人工智能的风险分为四个级别(△最小或无风险,△有限风险,△高风险,△不可接受的风险),并按照每个阶段规定了必须履行的义务。

具体来说,一是规定了高风险人工智能系统的人工监督。其原则是在制造过程中可以由人类监督的方式设计和开发高风险的人工智能系统。

二是规定了高风险人工智能系统运营者必须遵守的义务。例如,高风险的人工智能系统运营商在产品推出或服务推出之前必须经过合格评定。适宜性评估的内容包括分析高风险人工智能系统的潜在风险、评估可能对基本权利和安全造成的影响、是否采取措施减轻偏见以及数据的充分性。

第三,明确了高风险人工智能系统用户的义务。这里的用户是指基于自身权限使用人工智能系统的企业、事业单位、机构或其他组织,不包括执行非专业私人活动的用户。高风险人工智能系统的用户有义务警惕人工智能可能侵犯基本权利的可能性,并确保人工智能系统中的数据与其原始目的相关。

另外,如果人工智能系统可能侵犯人类健康、安全或基本权利,用户必须停止使用,并将该信息通知人工智能业务经营者或传播者。此外,用户必须将高风险人工智能系统的运行记录保存一定时间,以便后续诊断人工智能系统侵犯基本权利的原因。

该法案的重要意义在于它对人工智能技术做出了详细规定,值得注意的是它不仅规定了人工智能开发者的义务,还规定了用户的义务。它似乎是根据OECD、UNESCO等国际社会的讨论结果加以立法,预计今后将成为各国人工智能相关法律的参考。

美国《算法责任法》、人工智能行政命令

事实上,美国人工智能政策侧重于培育产业和支持国家层面人工智能的开发,因此比起欧盟以更加灵活的方式对待人工智能监管。但随着人工智能相关问题不断涌现,美国于2019年4月提出了《算法责任法》,要求只对自动化决策系统*中的高危系统,进行决策系统影响评估和个人信息影响评估。

在个人信息侵害、偏见/错误问题不断被提出的情况下,政府给予企业义务来对这些风险进行事先评估。

*任何使用计算的系统、软件或流程,其结果作为决策或判断依据。包括机器学习、统计或其他数据处理或人工智能技术衍生。

然而,2022年参众两院同时修订提出的《算法责任法案》,随着自动化决策系统使用领域的增加,其内容也大大扩展。首先,似乎应该对自动化决策系统和增强的关键决策流程进行影响评估**。

重要决策是指对消费者生活产生重大影响的决策,如教育、基础设施、医疗、金融等。影响评估的内容包括过去/当前的表现、减轻对消费者负面影响的措施以及加强个人信息保护的措施。

**使用自动化决策系统做出重要决策的流程、程序或其他活动。

另一个值得注意的点是,根据该法案,如果人工智能系统造成无理歧视或不符合个人信息侵权影响评估等,主管部门可能会采取执法行动。例如,如果公民受到人工智能系统的威胁或不利对待,州检察长可以代表受害者提起诉讼,寻求法律援助。

该法案强调算法的透明度和问责制,特别是规定公司有义务提前进行影响评估,并允许国家代表帮助因人工智能遭受意外损失的各方提起诉讼。

除此之外,美国还于23年10月发布了《关于安全可靠的人工智能开发和使用的行政命令》(Executive Order on the Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence)。

为了防止人工智能技术的滥用,对人工智能运营商施加了比以前的《算法责任法》更严格的义务。具体来说,开发包含重要决策过程的人工智能公司必须通过由政府组建的验证专家团队“红队”测试,即使服务启动后也应持续报告消费者的影响,政府有义务对此进行评估。

此外,国家标准技术研究所将制定标准,以确保人工智能的安全和信任,同时消除版权争议,并添加水印来识别人工智能产品,以防止虚假信息的传播。

表2) 全球主要政策/立法的内容

| 多边会议 | 人工智能峰会 (2023年11月) |

|

| 国际组织 | OECD人工智能建议 (2019年5月) |

|

| UNESCO人工智能道德建议 (2019年11月) |

|

|

| 主要法案 | EU人工智能法案通过 (2024年3月) |

|

| 美国算法责任法案提案 (2022年10月) |

|

|

| 美国人工智能行政命令 (2023年10月) |

|

根据这一全球趋势,韩国最近也出现了与人工智能相关的监管动向。首先,《人工智能版权指引》规定了人工智能创作的版权认定范围。此外,科学信息通信部提出的《人工智能基本法》在常委会全体会议上悬而未决一年多,人们的兴趣也有所增加。

由于该法案聚焦人工智能技术发展,坚持“先许可、后监管”的原则,因此难以提交全体会议。然而,随着国际趋势和人工智能相关副作用的凸显,如EU《人工智能法案》的通过、美国人工智能行政命令的公布,以及迫切需要法律和制度支持来提高国家人工智能水平的呼声越来越高。

为提高人工智能技术的竞争力并实现负责任的人工智能,该原则被删除。此外,韩国通信委员会在2024年3月的工作计划公告中宣布,将推动《人工智能服务用户保护法》的制定,并宣布计划引入人工智能产品标识制度和设立专门报告人工智能相关损失的窗口的计划。并且,韩国也正在陆续实施抑制人工智能副作用的监管。

全球政策/立法趋势的影响

迄今为止,我们已经研究了多边会议机构、国际组织和主要国家的人工智能相关法案和建议,它们具有几个值得注意的共同点。首先,人工智能开发者的角色和责任得到强化。开发者必须基于现有技术和信息将AI系统的质量保持在较高水平,并且必须透明地披露数据收集和处理的过程。

其次,强调主动发现和预防人工智能可能带来的风险。随着人工智能的快速发展,人工智能系统可能会侵犯平等和隐私等基本权利,因此需要重点防范风险。第三,由于人工智能基本上是从现有数据中学习并产生输出,因此强调版权保护。最后,由于人工智能引发的问题影响范围具有跨国性,建议通过国际合作和全球应对来解决问题。

因此,企业在开发和使用人工智能时,首先需要考虑强制组建红队(模拟敌人),提前发现人工智能开发过程中的漏洞。前面提到的美国人工智能行政命令也强制要求组建红队。为了在发布前验证系统,企业除了使用现有代码进行测试之外,还需要通过多种方式进行模拟攻击,例如为模型创建恶意提示和输入值。

据了解,谷歌正在通过与内部专家组成AI红队来模拟攻击,并鼓励外部人员参与Open AI的红队。必须通过基于红队的各种攻击方法来详细验证系统是否支持非法活动、提供有偏见的信息和判断、生成毒性内容以及侵犯个人信息,并防止风险。

此外,现在有必要记录内部开发人员的职责,例如通过人工智能系统的解释来提高透明度,并持续提供培训机会,以便他们能够掌握最新的技术。当前国际社会应对人工智能风险必须重视人工智能开发者的义务和责任。

第三,我们要全力保护版权,比如给生成式AI的输出加水印,保护人工智能学习中使用的创意作品和新闻的版权。为此,有必要考虑建立管理人工智能创作和现有内容的内部准则。最后,我们要不断发展技术,通过各类网络补齐漏洞。换句话说,人工智能应用技术必须不断补充和发展。

此外,即使在推出以多种网络及程序为基础的人工智能产品后,如果暴露出意想不到的弱点, 应立即向总公司申报,并构建能够立即进行分析的程序

参考文献

[1] 科学技术信息通信部,2023年11月7日,《参加人工智能稳定性峰会结果公告》,新闻稿。

[2] Kim Song-ok,2021年11月,最新趋势和人工智能立法面临的挑战 – EU 侧重于与法律体系的比较,「公法研究」。

[3] Kim Il-woo,2024,高风险人工智能系统中的歧视研究,「西江法律杂志」。

[4] Hyun-Kyung Kim,2022,UNESCO人工智能伦理建议问题分析和国内立法改进方向,「全球立法战略」。

[5] Noh Seong-Ho,2023,分析金融产业中人工智能(AI)应用方案带来的风险因素,「资本市场研究所」。

[6] 数字日报,2024.2.14,政府再次强调需要通过AI框架法案……目光聚焦过度防卫。

[7] 数字今日,2024.3.20,第22届国会最后一刻会通过人工智能基本法吗?。

[8] 每日经济新闻,2023年12月18日,AI创作的绘画和小说的版权不被认可……著作权登记规定中明确。

[9] 韩国通信委员会,2024年3月21日,2024年主要业务实施计划。

[10] 亚洲经济,2023年12月28日,人工智能版权第一指南…… “充足的补偿”与“落后于竞争” 。

[11] Seong-Tak Oh,2020年1月/2月,OECD 人工智能建议,《TTA Journal》。

[12] Jeong-Hyeon Yoon,2023年12月6日,Meaning of the布莱切利人工智能安全及影响峰会「国家安全战略研究所」。

[13] 财经新闻,2024年3月21日,《人工智能产品展示》 '强制的'…推动人工智能用户保护法颁布。

[14] 韩国经济日报,2024年3月22日,人工智能用户保护法正式生效...还将建立专门的人工智能损害报告窗口。

[15] Hong Seok-han 2023.4,对美国“2022算法责任法案”的考虑,《美国宪法研究》。

[16] EU, https://digital-strategy.ec.europa.eu/en/news

[17] Jacob Abernethy,2024年3月 - 4月,“将人类价值观带入人工智能”,《哈佛商业评论》。

[18] OECD,人工智能理事会的建议。

[19] UNESCO,关于人工智能伦理的建议。

▶ 本文为翻译作品,原文标题:AI 리스크에 대한 글로벌 대응 동향 및 시사점(全球应对人工智能风险的趋势及启示);

作者: Mijeong Han;

来源: https://www.samsungsds.com/kr/insights/ai-risks-and-responses.html

发布时间:2024-03-06

▶ 本文版权归原作者所有,未经事先同意,禁止对本文进行二次加工和商业使用。